Die Grafikkartentechnologien haben in den letzten Generationen sprunghafte Fortschritte gemacht, wobei jede Generation nicht nur die Gesamtleistung der Karten, sondern auch die Funktionen der Karten erheblich verbessert hat. Es ist keine Überraschung, dass es sowohl für Nvidia als auch für AMD von entscheidender Bedeutung ist, die Funktionen ihrer Karten und die darin enthaltenen Technologien sowie die generationsbedingten Leistungsverbesserungen bei jeder nachfolgenden Reihe von Grafikkarten weiter zu verbessern und weiterzuentwickeln.

Die Nvidia GeForce RTX 3080 ist eine der schnellsten Grafikkarten, die Ray Tracing unterstützen - Bild: Nvidia

Die Erhöhung der Taktrate ist heutzutage ein Hauptmerkmal in der PC-Hardware-Branche, da sowohl die Grafikkarten als auch die CPUs diese Technologie anbieten. Das Variieren der Taktraten der Komponente aufgrund von Änderungen in den Bedingungen des PCs kann zu einer stark verbesserten Leistung sowie zur Effizienz dieses Teils führen, was letztendlich eine viel bessere Benutzererfahrung bietet. Aufgrund der raschen Fortschritte in diesem Bereich wurde das Standard-Boosting-Verhalten von Grafikkarten jedoch weiter verbessert und verfeinert, wobei Technologien wie GPU Boost 4.0 im Jahr 2020 in den Vordergrund gerückt sind. Diese neuen Technologien wurden entwickelt, um die Leistung der Grafikkarte zu maximieren wenn es notwendig ist und gleichzeitig die maximale Effizienz unter leichteren Lasten erhalten bleibt.

GPU-Boost

Was genau ist GPU Boost? Einfach ausgedrückt ist GPU Boost die Methode von Nvidia, die Taktraten der Grafikkarten dynamisch zu erhöhen, bis die Karten ein vorbestimmtes Leistungs- oder Temperaturlimit erreichen. Der GPU-Boost-Algorithmus ist ein hochspezialisierter und bedingt bewusster Algorithmus, der Änderungen in Sekundenbruchteilen an einer großen Anzahl von Parametern vornimmt, um die Grafikkarte auf ihrer maximal möglichen Boost-Frequenz zu halten. Diese Technologie ermöglicht es der Karte, einen viel höheren Boost als die angekündigte „Boost Clock“ zu erzielen, die möglicherweise auf der Verpackung oder auf der Produktseite aufgeführt ist.

Mit GPU Boost kann die Karte ihre Leistung mithilfe der verfügbaren Ressourcen maximieren - Bild: Nvidia

Bevor wir uns mit dem Mechanismus dieser Technologie befassen, müssen einige wichtige Begriffe erklärt und differenziert werden.

Terminologien

Beim Kauf einer Grafikkarte kann der Durchschnittsverbraucher auf eine Vielzahl von Zahlen und verwirrenden Terminologien stoßen, die wenig Sinn machen oder sogar noch schlimmer sind, sich gegenseitig widersprechen und den Käufer weiter verwirren. Daher ist es erforderlich, einen kurzen Blick auf die Bedeutung der verschiedenen terminologiebezogenen Terminologien zu werfen, wenn Sie eine Produktseite betrachten.

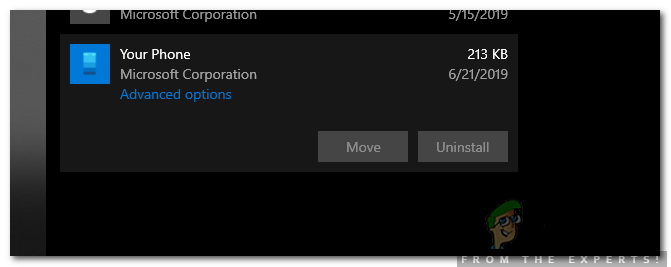

- Basisuhr: Der Basistakt einer Grafikkarte (manchmal auch als „Kerntakt“ bezeichnet) ist die Mindestgeschwindigkeit, mit der die GPU ausgeführt werden soll. Unter normalen Bedingungen fällt die GPU der Karte nicht unter diese Taktrate, es sei denn, die Bedingungen werden erheblich geändert. Diese Zahl ist bei älteren Karten bedeutender, wird jedoch immer weniger relevant, da Boosting-Technologien im Mittelpunkt stehen.

- Boost Clock: Der angekündigte Boost-Takt der Karte ist die maximale Taktrate, die die Grafikkarte unter normalen Bedingungen erreichen kann, bevor der GPU-Boost aktiviert wird. Diese Taktzahl ist im Allgemeinen etwas höher als die Basisuhr, und die Karte verbraucht den größten Teil ihres Strombudgets, um diese Zahl zu erreichen. Sofern die Karte nicht thermisch eingeschränkt ist, wird diese angekündigte Boost-Uhr erreicht. Dies ist auch der Parameter, der in 'Factory Overclocked' -Karten von AIB-Partnern geändert wird.

- 'Spieluhr': Mit der Veröffentlichung der neuen RDNA-Architektur von AMD auf der E3 2019 kündigte AMD auch ein neues Konzept an, das als Game Clock bekannt ist. Dieses Branding gilt zum Zeitpunkt des Schreibens ausschließlich für AMD-Grafikkarten und gibt den willkürlichen Taktraten, die beim Spielen auftreten würden, einen Namen. Grundsätzlich ist Game Clock die Taktrate, die die Grafikkarte während des Spielens schlagen und beibehalten soll. Diese liegt im Allgemeinen irgendwo zwischen Base Clock und Boost Clock für AMD-Grafikkarten. Das Übertakten der Karte wirkt sich direkt auf diese bestimmte Taktrate aus.

Die beworbenen Basis- und Boost-Uhren der GeForce RTX 3070 - Bild: TechPowerUp

Mechanismus des GPU-Boosts

GPU Boost ist eine interessante Technologie, die für Gamer von großem Vorteil ist und sozusagen keinen wesentlichen Nachteil hat. GPU Boost erhöht die effektive Taktrate der Grafikkarte sogar über die angegebene Boost-Frequenz hinaus, sofern bestimmte Bedingungen günstig sind. Was GPU Boost macht, ist im Wesentlichen Übertakten, bei dem die Taktrate der GPU über den angekündigten „Boost Clock“ hinausgeschoben wird. Dadurch kann die Grafikkarte automatisch mehr Leistung erzielen, und der Benutzer muss überhaupt nichts ändern. Der Algorithmus ist im Wesentlichen „intelligent“, da er verschiedene Parameter in Sekundenbruchteilen gleichzeitig ändern kann, um die anhaltende Taktrate so hoch wie möglich zu halten, ohne dass das Risiko eines Absturzes oder eines Artefakts usw. besteht Grafikkarten bieten sofort höhere Taktraten als angegeben, wodurch der Benutzer im Wesentlichen eine übertaktete Karte erhält, ohne dass eine manuelle Abstimmung erforderlich ist.

GPU Boost ist hauptsächlich ein Nvidia-spezifisches Branding und AMD hat etwas Ähnliches, das anders funktioniert. In diesem Artikel konzentrieren wir uns hauptsächlich auf die Implementierung von GPU Boost durch Nvidia. Mit seiner Turing-Reihe von Grafikkarten Nvidia führte die vierte Iteration von GPU Boost mit dem Namen GPU Boost 4.0 ein, mit der die Benutzer die von GPU Boost verwendeten Algorithmen manuell anpassen konnten, wenn sie dies für richtig hielten. Dies war mit GPU Boost 3.0 nicht möglich, da diese Algorithmen in den Treibern gesperrt waren. Mit GPU Boost 4.0 hingegen können Benutzer verschiedene Kurven manuell anpassen, um die Leistung zu steigern. Dies ist eine gute Nachricht für Overclocker und Enthusiasten.

GPU Boost 4.0 hat auch verschiedene andere Feinänderungen hinzugefügt, z. B. den Temperaturbereich, in dem neue Wendepunkte hinzugefügt wurden. Im Gegensatz zu GPU Boost 3.0, bei dem ein steiler und plötzlicher Abfall vom Boost-Takt zum Basistakt auftrat, als eine bestimmte Temperaturschwelle überschritten wurde, können jetzt mehrere Schritte zwischen den beiden Taktraten erfolgen. Dies ermöglicht ein höheres Maß an Granularität, wodurch die GPU auch unter ungünstigen Bedingungen selbst das letzte Stück Leistung beeinträchtigen kann.

PU Boost 4.0 ermöglicht zusätzliche benutzerdefinierte Schritte zwischen dem ursprünglichen Boost-Takt und dem Basistakt - Bild: Nvidia

Das Übertakten der Grafikkarten mit GPU-Boost ist recht unkompliziert und hat sich in dieser Hinsicht nicht wesentlich geändert. Jeder zusätzliche Offset zum Kerntakt wird tatsächlich auf den „Boost-Takt“ angewendet, und der GPU-Boost-Algorithmus versucht, die höchste Taktrate mit einem ähnlichen Abstand weiter zu verbessern. Das Erhöhen des Schiebereglers für die Leistungsbegrenzung auf das Maximum kann in dieser Hinsicht erheblich hilfreich sein. Dies macht das Stresstest der Übertaktung etwas komplizierter, da der Benutzer die Taktraten sowie die Temperaturen, den Stromverbrauch und die Spannungszahlen im Auge behalten muss unser umfassender Leitfaden für Stresstests kann bei diesem Prozess helfen.

Bedingungen für GPU Boost

Nachdem wir den Mechanismus hinter GPU Boost selbst besprochen haben, ist es wichtig, die Bedingungen zu erörtern, die erfüllt sein müssen, damit GPU Boost effektiv ist. Es gibt eine große Anzahl von Bedingungen, die sich auf die Endfrequenz auswirken können, die durch GPU Boost erreicht wird, aber es gibt drei Hauptbedingungen, die den größten Einfluss auf dieses Boosting-Verhalten haben.

Power Headroom

GPU Boost übertaktet die Karte automatisch, sofern der Karte genügend Headroom zur Verfügung steht, um höhere Taktraten zu ermöglichen. Es ist verständlich, dass höhere Taktraten mehr Strom aus dem Netzteil ziehen. Daher ist es äußerst wichtig, dass der Grafikkarte genügend Strom zur Verfügung steht, damit GPU Boost ordnungsgemäß funktioniert. Mit den meisten modernen Nvidia-Grafikkarten verbraucht GPU Boost die gesamte verfügbare Leistung, um die Taktraten so hoch wie möglich zu halten. Dies macht den Power Headroom zum häufigsten einschränkenden Faktor für den GPU-Boost-Algorithmus.

GPU Boost kann stark von Power Limit abhängen - Bild: Nvidia

Das einfache Erhöhen des Schiebereglers „Power Limit“ auf das Maximum in jeder Übertaktungssoftware kann einen großen Einfluss auf die endgültigen Frequenzen haben, die von der Grafikkarte getroffen werden. Die zusätzliche Leistung, die der Karte zur Verfügung gestellt wird, wird verwendet, um die Taktrate noch weiter zu erhöhen. Dies ist ein Beweis dafür, wie stark der GPU-Boost-Algorithmus vom Leistungsspielraum abhängt.

Stromspannung

Das Stromversorgungssystem der Grafikkarte muss in der Lage sein, die zusätzliche Spannung bereitzustellen, die erforderlich ist, um die höheren Taktraten zu erreichen und aufrechtzuerhalten. Die Spannung trägt ebenfalls direkt zur Temperatur bei, sodass sie auch mit dem Zustand der thermischen Kopffreiheit zusammenhängt. Unabhängig davon gibt es eine feste Grenze für die Spannung, die die Karte verwenden kann, und diese Grenze wird vom BIOS der Karte festgelegt. GPU Boost nutzt jeden Spannungsspielraum, um die höchstmögliche Taktrate aufrechtzuerhalten.

Die Spannung wirkt sich auch auf die endgültigen Taktraten aus - Bild: Nvidia

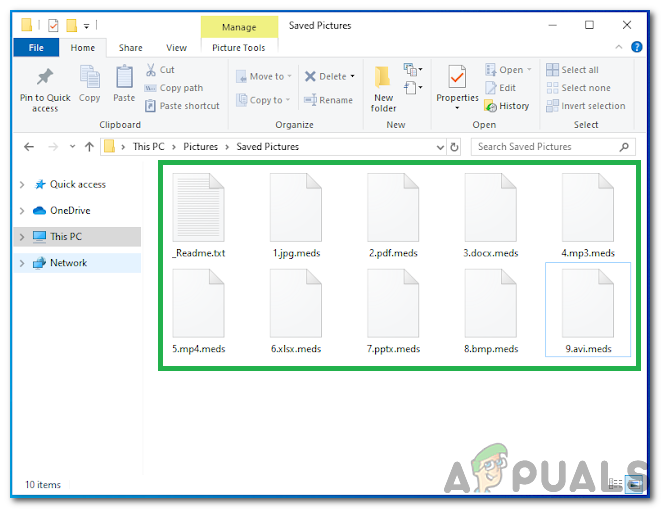

Thermische Kopffreiheit

Die dritte wichtige Bedingung, die für den effektiven Betrieb von GPU Boost erfüllt sein muss, ist die Verfügbarkeit eines angemessenen thermischen Headrooms. GPU Boost reagiert extrem empfindlich auf die Temperatur der GPU, da es die Taktrate selbst bei geringsten Temperaturänderungen erhöht und verringert. Es ist wichtig, die Temperatur der GPU so niedrig wie möglich zu halten, um die höchsten Taktraten zu erzielen.

Bei Temperaturen über 75 Grad Celsius sinkt die Taktrate merklich, was sich auf die Leistung auswirken kann. Die Taktrate bei diesen Temperaturen wird wahrscheinlich immer noch höher sein als bei der Boost-Uhr. Es ist jedoch keine gute Idee, die Leistung auf dem Tisch zu lassen. Daher kann eine ausreichende Belüftung des Gehäuses und ein gutes Kühlsystem an der GPU selbst einen erheblichen Einfluss auf die durch GPU Boost erzielten Taktraten haben.

Boost Binning und thermische Drosselung

Ein interessantes Phänomen, das dem Betrieb von GPU Boost eigen ist, wird als Boost Binning bezeichnet. Wir wissen, dass der GPU-Boost-Algorithmus die Taktrate der GPU in Abhängigkeit von verschiedenen Faktoren schnell ändert. Die Taktrate wird tatsächlich in Blöcken von jeweils 15 MHz geändert, und diese 15-MHz-Teile der Taktraten werden als Boost-Bins bezeichnet. Es ist leicht zu beobachten, dass die GPU-Boost-Zahlen je nach Leistung, Spannung und thermischem Headroom um den Faktor 15 MHz voneinander abweichen. Dies bedeutet, dass durch Ändern der zugrunde liegenden Bedingungen die Taktrate der Karte jeweils um den Faktor 15 MHz verringert oder erhöht werden kann.

Das Konzept der thermischen Drosselung ist auch beim GPU-Boost-Betrieb interessant zu untersuchen. Die Grafikkarte beginnt erst dann mit der thermischen Drosselung, wenn sie eine festgelegte Temperaturgrenze erreicht hat, die als Tjmax bekannt ist. Diese Temperatur entspricht normalerweise zwischen 87 und 90 Grad Celsius auf dem GPU-Kern, und diese spezifische Zahl wird vom BIOS der GPU bestimmt. Wenn der GPU-Kern diese eingestellte Temperatur erreicht, fallen die Taktraten allmählich ab, bis sie sogar unter den Basistakt fallen. Dies ist ein sicheres Zeichen für eine thermische Drosselung im Vergleich zu einem regulären Boost-Binning, das durch GPU-Boost durchgeführt wird. Der Hauptunterschied zwischen thermischer Drosselung und Boost-Binning besteht darin, dass die thermische Drosselung bei oder unter dem Basistakt erfolgt und das Boost-Binning die maximale Taktrate ändert, die durch GPU-Boost unter Verwendung der Temperaturdaten erreicht wird.

Nachteile

Es gibt nicht viele Nachteile dieser Technologie, die an und für sich eine ziemlich kühne Aussage über eine Grafikkartenfunktion sind. Mit GPU Boost kann die Karte ihre Taktraten automatisch ohne Benutzereingabe erhöhen und das volle Potenzial der Karte freischalten, indem dem Benutzer zusätzliche Leistung ohne zusätzliche Kosten geboten wird. Wenn Sie eine Nvidia-Grafikkarte mit GPU Boost besitzen, sollten Sie jedoch einige Dinge beachten.

Aufgrund der Tatsache, dass die Karte das gesamte ihr zugewiesene Strombudget verwendet, sind die Stromverbrauchszahlen der Karte höher als die angegebenen TBP- oder TGP-Zahlen vermuten lassen. Darüber hinaus führt der zusätzliche Spannungs- und Stromverbrauch zu höheren Temperaturen, da die Karte automatisch übertaktet wird, indem der ihr zur Verfügung stehende Temperaturspielraum genutzt wird. Die Temperaturen werden auf keinen Fall gefährlich hoch, denn sobald die Temperaturen einen bestimmten Grenzwert überschreiten, werden die Spannung und der Stromverbrauch gesenkt, um die zusätzliche Wärme auszugleichen.

Der Leistungsverbrauch kann mit GPU Boost über das angekündigte TBP (320 W bei RTX 3080) hinaus steigen - Bild: Techspot

Letzte Worte

Dank der rasanten Fortschritte bei den Grafikkartentechnologien sind einige äußerst beeindruckende Funktionen in die Hände der Verbraucher gelangt, und GPU Boost ist sicherlich eine davon. Mit der Funktion von Nvidia (und der ähnlichen Funktion von AMD) können die Grafikkarten ihr maximales Potenzial erreichen, ohne dass Benutzereingaben erforderlich sind, um die maximal mögliche Standardleistung zu erzielen. Diese Funktion macht manuelles Übertakten so gut wie überflüssig, da aufgrund der hervorragenden Verwaltung von GPU Boost nicht viel Spielraum für manuelle Feinabstimmung zur Verfügung steht.

Insgesamt ist GPU Boost eine hervorragende Funktion, die wir mit Verbesserungen des Kernalgorithmus hinter dieser Technologie, die die winzigen Anpassungen an verschiedenen Parametern mikromanagt, um die bestmögliche Leistung zu erzielen, immer besser sehen möchten.